IP-Adapterを使用し、参照画像の特徴を生成画像に反映させるための具体的な設定手順です。試行錯誤の結果、エラーを回避しつつ、実用的なレベルで反映を確認できた構成をまとめました。

IP-Adapterとは?

テキストプロンプトだけでなく、「画像」を直接AIへの入力として与えるための拡張機能です。 特定のキャラクターの顔立ちや、イラスト全体の雰囲気などを、言葉で説明する代わりに画像で指示するために使用します。

実践した設定手順

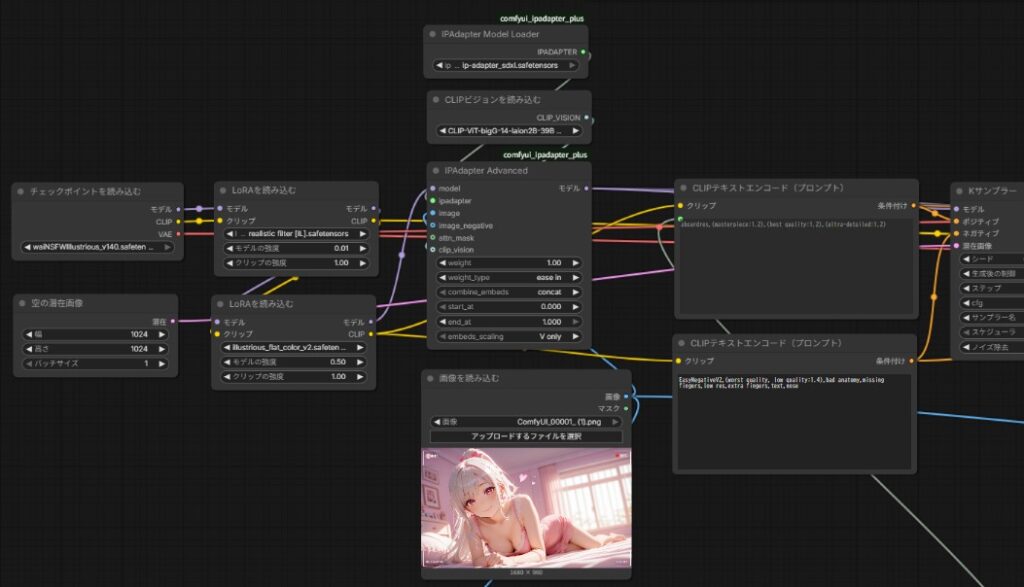

今回は今まで作った画像生成用のワークフローにIPAdapter関連のノードを接続しました。LoRAとKサンプラーの間にIPAdapter関連のノードを接続しています。

使用ノード

今回、新たに使用したノードは4つです。

上の2つはManagerからcomfyui_ipadapter_plusをインストールすれば使えるようになります。

・「IPAdapter Model Loader」ノード

・「IPAdapter Advanced」ノード

・「CLIPビジョンを読み込む」ノード

・「画像を読み込む」ノード

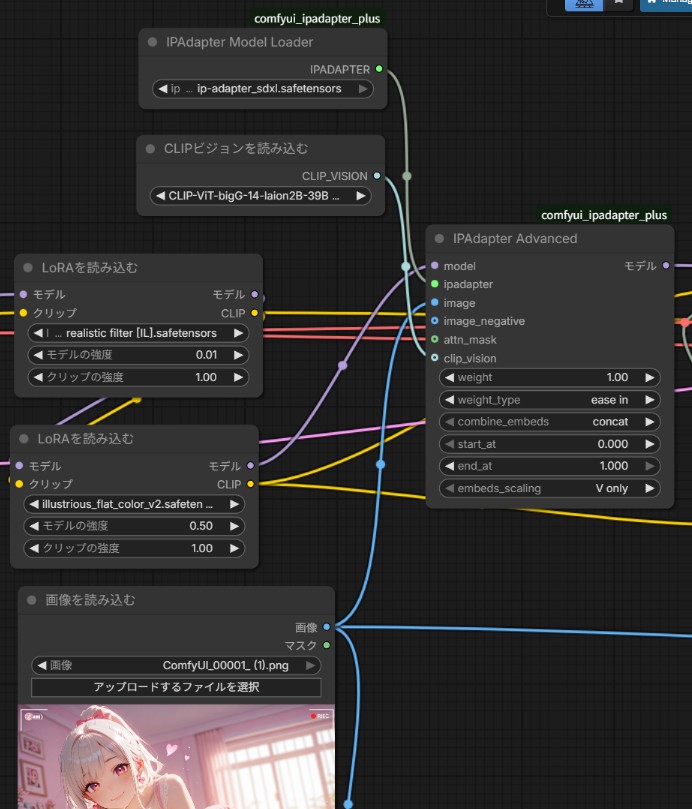

ノードの接続

図のように接続します。

- Checkpoint / LoRA → IPAdapter Advanced(model入力へ)

- IPAdapter Model Loader → IPAdapter Advanced(ipadapter入力へ)

- CLIPビジョンを読み込む → IPAdapter Advanced(clip_vision入力へ)

- 画像を読み込む → IPAdapter Advanced(image入力へ)

- IPAdapter Advanced → KSampler(model入力へ)

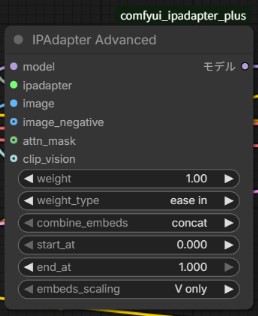

IPAdapter Advancedの設定

私の場合、weight_typeを「ease in」にしました。それ以外を入れると全然機能しませんでした・・・

IPAdapter Model Loaderの設定

ip-adapter_sdxl.safetensorsを選択します。無い場合はダウンロードしてください。

CLIPビジョンを読み込むの設定

CLIP-ViT-bigG-14-laion2B-39B-b160k.safetensorsを選択します。無い場合はダウンロードしてください。

画像を読み込むの設定

参照にさせたいキャラクターなどのイラストをここで設定してください。

実践

実際にやってみました。プロンプトは女性の外見に関する部分のみを削除してあります。

左が参照画像、右が出力画像です。

目の色や髪の色(少しピンクだが)がプロンプトで指定しなくても同じ設定で出力されました。

ただ髪型(ポニーテール)は何度やっても参照してくれませんでした。

まとめ

今回はシンプルながらかなり苦戦しました。IPAdapter ModelやCLIPビジョンを別のものにするとエラーが出て使えなったからです。この組み合わせでエラーが無くせました。

次に出力結果でまた悩みました。AIに聞くとweight_typeを「style transfer」か「composion」にしてくださいと言われたけど、出力結果が酷いできで、AIに聞いてもたいした解決策も帰ってこず・・

なので設定値を自分で一通り試してみました。結果として「ease in」が一番良かった、というかこれ以外はあまり使えない感じでした。

この辺りは環境によって違うかもしれないので自分で確かめてみてください。

正直このIPAdapterの使いどころが私にはまだわかりません^^;今まで使ってなかったし

苦労した割に、このワークフローは埃をかぶりそうな予感・・・

ただ、この先何があるのかわからないので活躍してくれるかもしれません!

コメント